Daftar Isi Artikel

- Benchmark Reasoning 2025, GPT-5 vs Claude vs Gemini

- SWE bench Verified, tolok ukur agentic coding yang mendekati produksi

- GPQA Diamond, pengukur penalaran sains tingkat doktoral

- Tabel Perbandingan Reasoning 2025

- Cara Memilih Model Reasoning Sesuai Kebutuhan Anda

- Strategi Operasional, hemat biaya tanpa mengorbankan akurasi

- Metodologi Perbandingan, apa yang perlu Anda perhatikan sebelum menyimpulkan

- Pemetaan Use Case Reasoning ke KPI Bisnis

- KPI inti untuk benchmark reasoning

- Cara menghubungkan angka benchmark ke KPI

- Hitung KPI Reasoning, Biaya, dan ROI Secara Instan

- Latensi, Throughput, dan Anggaran, mengelola trade off performa

- Kerangka keputusan performa, dari ringkas ke mendalam

- Taktik manajemen performa yang terbukti efektif

- Metrik operasional dan cara membacanya

- Ambang SLO yang praktis untuk start

- Rumus sederhana yang berguna di rapat

- Contoh kebijakan operasional siap pakai

- Dashboard minimal yang perlu ada tiap hari

- Tata Kelola, Auditability, dan Kepatuhan untuk Reasoning

- Pemeriksaan Manusia pada Keputusan Kritis

- Metodologi Uji Internal, dari Validasi Sampel ke Evaluasi Berkelanjutan

- Ruang lingkup dan definisi keberhasilan

- Desain dataset yang representatif

- Rubric penilaian yang konsisten

- Pelabelan dan kontrol kualitas anotasi

- Metrik inti dan pelaporan

- Pipeline evaluasi yang berulang

- Regression test terjadwal

- Gerbang perubahan, dari eksperimen ke rilis

- Pelaporan, dashboard, dan audit

- Template data dan struktur berkas

- Verifier ringan untuk pemicu fallback

- Risiko umum dan mitigasi

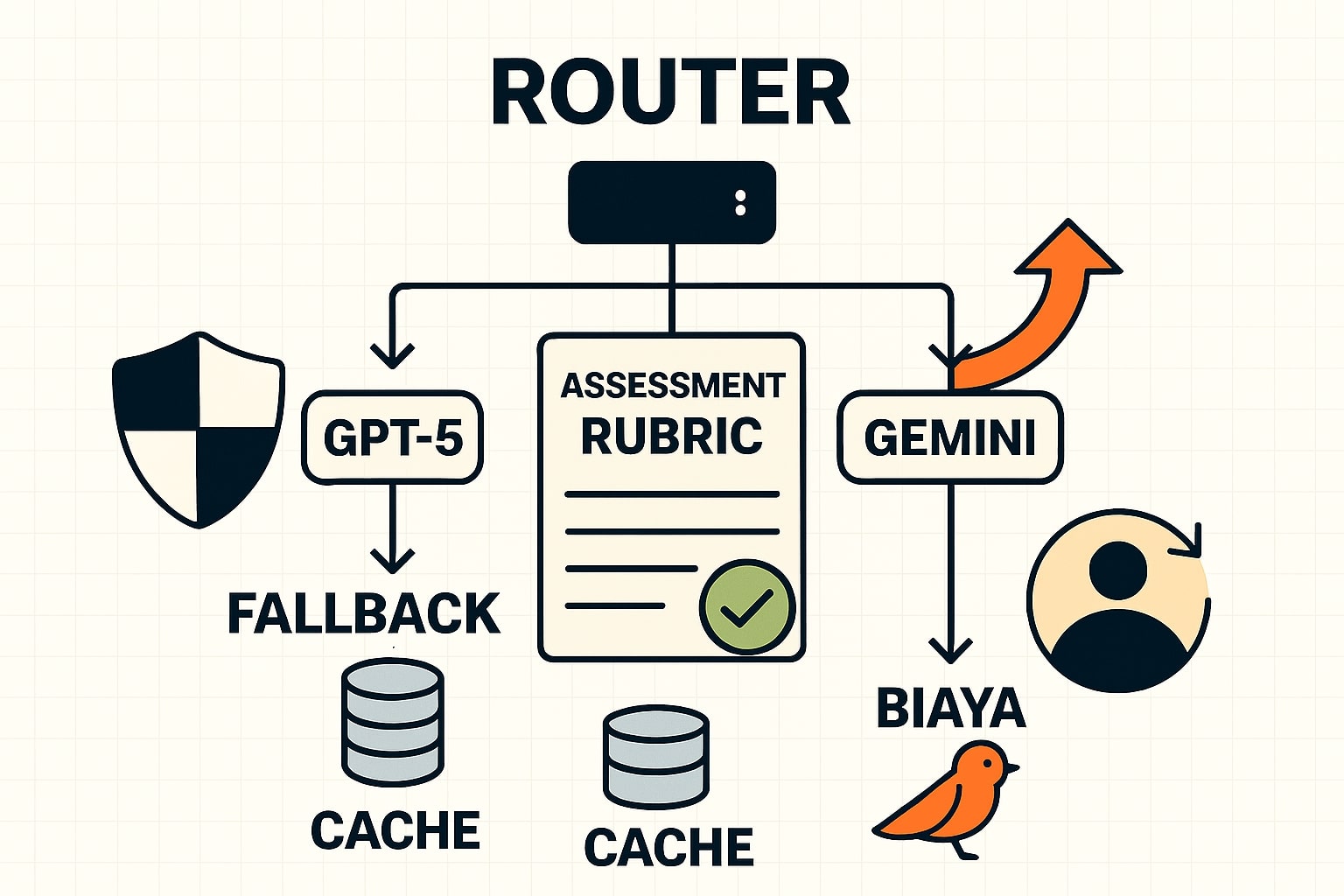

- Arsitektur Multi Model untuk Routing Cerdas dan Fallback

- Prinsip inti yang perlu Anda pegang

- Pola arsitektur yang praktis

- Observabilitas dan SLO agar tidak berjalan dalam gelap

- Contoh kebijakan routing yang enak dipakai tim

- Praktik Prompting untuk Reasoning, template siap pakai

- Template 1, Investigasi bug pada repositori kode

- Template 2, Ringkas riset teknis dengan sitasi terverifikasi

- Template 3, Analisis komparatif dan rekomendasi keputusan

- Rencana 14 Hari Mengadopsi Reasoning di Tim

- Langkah Lanjut, Terapkan Benchmark Reasoning di Pekerjaan Anda

Margabagus.com – Performa reasoning merupakan jantung manfaat AI untuk pekerjaan nyata, dari mulai melakukan debugging kode hingga analisis riset yang sensitif terhadap masalah biaya. Pada pertengahan 2025, tiga pemain besar menjadi rujukan, ChatGPT berbasis GPT-5 dari OpenAI, Claude Opus 4.1 dari Anthropic, dan Gemini 2.5 Flash dari Google. Ketiganya menawarkan mode berpikir yang dapat diatur, kapan cepat dan kapan perlu menalar lebih dalam, sehingga Anda bisa menyeimbangkan akurasi, latensi, dan biaya dalam proses kerja sehari-hari. Pada saat rilis Agustus 2025, OpenAI melaporkan GPT-5 memimpin pada beberapa tolak ukur seperti AIME 2025 dan SWE bench Verified, sementara Anthropic merilis Claude Opus 4.1 dengan skor coding yang sangat kompetitif, dan Google menerbitkan model card Gemini 2.5 Flash lengkap dengan hasil GPQA yang kuat serta thinking yang dapat ditinjau.[1] [2] [3] [6] [7]

Benchmark Reasoning 2025, GPT-5 vs Claude vs Gemini

Perbandingan singkat lintas model.

Angka benchmark membantu mengestimasi reliabilitas model di tugas bernilai bisnis. Untuk pembaca teknologi dan bisnis, dua metrik paling relevan adalah SWE bench Verified yang mendekati pekerjaan pengembang, dan GPQA Diamond yang mengukur penalaran sains tingkat lanjut. GPT-5 mencatat 74,9 persen pada SWE bench Verified serta 88 persen pada Aider Polyglot, dengan varian Pro mencapai skor GPQA lebih tinggi, sedangkan Claude Opus 4.1 mencatat 74,5 persen pada SWE bench Verified, dan Gemini 2.5 Flash melaporkan GPQA Diamond 82,8 persen pass at 1 serta SWE bench Verified 60,4 persen pada model card resmi.[2] [3] [6]

SWE bench Verified, tolok ukur agentic coding yang mendekati produksi

SWE bench Verified menguji kemampuan model memahami repositori data, mengedit kode, serta memverifikasi perbaikan. Evaluasi ini relevan untuk tim yang mengejar MTTR rendah, karena menilai kemampuan navigasi kode dan ketelitian verifikasi. OpenAI mencatat bahwa skor GPT-5 dihitung pada subset 477 masalah yang lolos verifikasi infrastruktur internal, sementara Anthropic menilai seri Claude pada 500 masalah, ini perlu dicermati saat Anda membandingkan angka antar vendor.[1] [3] [5]

GPQA Diamond, pengukur penalaran sains tingkat doktoral

GPQA Diamond menguji pertanyaan sains kompleks dengan jawaban pilihan ganda, di mana reasoning dan ketelitian pengetahuan menjadi kunci. GPT-5 Pro dilaporkan menorehkan skor tertinggi internal OpenAI pada GPQA, sementara Gemini 2.5 Flash mencatat 82,8 persen pass at 1 pada model card, informasi ini berguna ketika Anda menangani domain sains terapan yang menuntut langkah berlogika konsisten.[1] [6]

Tabel Perbandingan Reasoning 2025

| Dimensi | ChatGPT, GPT-5 | Claude Opus 4.1 | Gemini 2.5 Flash |

|---|---|---|---|

| Fokus kemampuan reasoning | Extended reasoning adaptif untuk tugas teknis bernilai tinggi [1] [2] | Hybrid reasoning untuk agentic search panjang dan refactoring multi berkas [3] [4] | Thinking hemat biaya dengan hasil seimbang untuk volume kueri tinggi [6] [7] |

| SWE bench Verified, agentic coding | 74,9% vendor reported, subset isu 477 [2] | 74,5% vendor reported, 500 isu [3] | 60,4% model card resmi [6] |

| GPQA Diamond, penalaran sains | Skor tertinggi dicapai GPT-5 Pro, OpenAI melaporkan SOTA internal [1] | Kuat untuk riset mendalam, angka bergantung konfigurasi thinking [3] [4] | 82,8% pass at 1 pada model card [6] |

| Kontrol tingkat reasoning | Pilih reasoning effort dan verbosity di API, thinking lebih efisien [2] | Thinking dengan ringkasan langkah untuk audit internal [3] | Thinking dapat ditinjau, batasan dan cutoff dijelaskan [6] [7] |

| Multimodal dan konteks panjang | Kuat pada teks, kode, dan multimodal, unggul di AIME dan MMMU [1] [2] | Stabil pada dokumen panjang dan analisis berurutan [4] | Kompeten multimodal cepat untuk pipeline konten visual [6] [7] |

| Orientasi biaya dan performa | Optimasi untuk tugas berdampak besar, lebih efisien daripada o3 pada alat dan token [2] | Seimbang akurasi dan jejak proses yang jelas [3] | Harga bersahabat untuk reasoning volume tinggi [7] |

| Catatan metodologi evaluasi | Subset SWE bench 477 masalah di infrastruktur internal [1] [2] | Skor dilaporkan dari 500 masalah dengan alat bash dan edit berkas [3] | Semua angka pass at 1 di model card, cutoff Januari 2025 [6] |

Baca juga artikel tentang CodeGen: Perbandingan CodeGen: ChatGPT vs Claude vs Gemini

Cara Memilih Model Reasoning Sesuai Kebutuhan Anda

Pohon keputusan pemilihan model

Kebutuhan bisnis berbeda, sehingga pilihan model perlu menimbang profil tugas, toleransi risiko, dan anggaran. Untuk agen coding yang harus menuntaskan isu bernilai tinggi, margin akurasi ekstra dari GPT-5 dan presisi refactoring Claude 4.1 akan terasa langsung di metrik tim. Untuk operasi konten dan analitik multimodal biaya terkontrol, Gemini 2.5 Flash menawarkan thinking yang cukup dengan harga efisien, terutama pada volume kueri tinggi. [2] [3] [7]

-

Agen coding dan perbaikan bug pada repositori besar, gunakan GPT-5 sebagai mesin patch dengan verifikasi ketat, siapkan Claude 4.1 untuk pekerjaan refactoring panjang dan review rinci.[2] [3]

-

Riset teknis dan dokumentasi panjang, GPT-5 Pro kuat pada GPQA, Claude efektif untuk penelusuran berjam jam, Gemini 2.5 Flash cocok untuk ringkasan volume besar yang sensitif biaya.[1] [3] [7]

-

Aplikasi multimodal cepat, Gemini 2.5 Flash memberikan hasil memadai dengan thinking yang dapat ditinjau, rute pertanyaan yang menuntut presisi tinggi ke GPT-5.[6] [1]

Strategi Operasional, hemat biaya tanpa mengorbankan akurasi

Strategi rute cerdas bekerja baik di lingkungan bisnis, kirim kueri sederhana ke profil thinking minimal, eskalasi otomatis ke extended reasoning saat sinyal risiko meningkat. Terapkan caching prompt dan batching, lalu ukur biaya per jawaban benar yang divalidasi. OpenAI melaporkan GPT-5 lebih hemat pada token keluaran dan panggilan alat dibanding model reasoning generasi sebelumnya, sementara Gemini 2.5 Flash menegaskan tujuan thinking hemat biaya pada model card resmi.[2] [6] [7]

Metodologi Perbandingan, apa yang perlu Anda perhatikan sebelum menyimpulkan

Periksa catatan metode terlebih dahulu.

Perbandingan lintas vendor tidak selalu lurus, periksa jumlah soal, penggunaan alat, dan kebijakan pass at 1. OpenAI menggunakan subset 477 masalah untuk evaluasi SWE bench pada infrastruktur internal, Anthropic melaporkan pada 500 masalah dengan alat tertentu, Google memaparkan seluruh angka sebagai pass at 1 dan menjelaskan batas thinking serta cutoff pengetahuan Januari 2025.[1] [3] [6] [5]

Pemetaan Use Case Reasoning ke KPI Bisnis

Keputusan memilih model sebaiknya ditautkan ke KPI nyata, bukan sekadar angka benchmark. Untuk tim engineering, dampaknya muncul pada MTTR, first pass fix rate, dan stabilitas patch setelah deploy. Untuk tim analitik dan produk, dampaknya terlihat pada biaya per jawaban benar, waktu ke wawasan yang dapat ditindaklanjuti, dan penurunan insiden revisi karena halusinasi.

KPI inti untuk benchmark reasoning

-

Agen coding, MTTR, first pass fix rate, regresi pasca patch, nilai bisnis per isu tertutup.

-

Riset dan dokumentasi, biaya per jawaban benar yang tervalidasi, waktu ke ringkasan, akurasi sitasi.

-

Multimodal konten, kecepatan produksi, tingkat revisi editorial, dan konsistensi gaya merek.

Cara menghubungkan angka benchmark ke KPI

-

SWE bench ke MTTR, gunakan korelasi konservatif dari skor sukses ke peluang perbaikan tuntas, lalu uji pada data internal.

-

GPQA ke kualitas riset, jadikan ambang minimal untuk pertanyaan sains dan teknis yang berisiko tinggi, aktifkan extended reasoning saat melewati ambang tersebut.

-

Aider Polyglot ke produktivitas edit kode, gunakan untuk memperkirakan penghematan sesi review dan jumlah komentar revisi.

Hitung KPI Reasoning, Biaya, dan ROI Secara Instan

Keputusan yang kuat lahir dari angka yang jelas, bukan tebakan. Dengan kalkulator ini, Anda bisa mensimulasikan dampak routing reasoning terhadap biaya, akurasi, dan waktu penyelesaian tugas dalam hitungan detik. Saya sarankan mulai dari nilai konservatif, naikkan porsi eskalasi hanya untuk kasus berisiko, lalu amati perubahan biaya per jawaban benar dan MTTR. Jika tren biaya naik tanpa peningkatan akurasi yang berarti, kecilkan panggilan extended reasoning, rapikan prompt, dan ulangi sampai menemukan titik manis antara presisi, kecepatan, dan anggaran.

Kalkulator KPI Reasoning dengan Routing Cerdas

Routing ke Extended Reasoning

Cara membaca hasil kalkulator KPI reasoning

- Biaya per jawaban benar, indikator efisiensi anggaran, semakin kecil semakin baik untuk operasi berskala.

- Jawaban benar per bulan, proyeksi keluaran berkualitas, cocok menilai dampak eskalasi ke extended reasoning.

- Waktu per tugas, pendekatan MTTR fungsional, gunakan untuk mengevaluasi produktivitas tim dan SLA internal.

- ROI estimasi, aktif jika Anda mengisi nilai per jawaban benar, jadikan sinyal awal lalu validasi dengan data bisnis Anda.

Catatan praktis

Jalankan dua skenario, profil konservatif dengan porsi eskalasi kecil dan profil agresif dengan porsi eskalasi lebih besar, bandingkan biaya per jawaban benar, waktu per tugas, dan perubahan ROI. Jika biaya melampaui ambang bulanan, turunkan porsi eskalasi, kurangi panggilan per tugas, atau optimalkan prompt agar thinking tetap efisien.

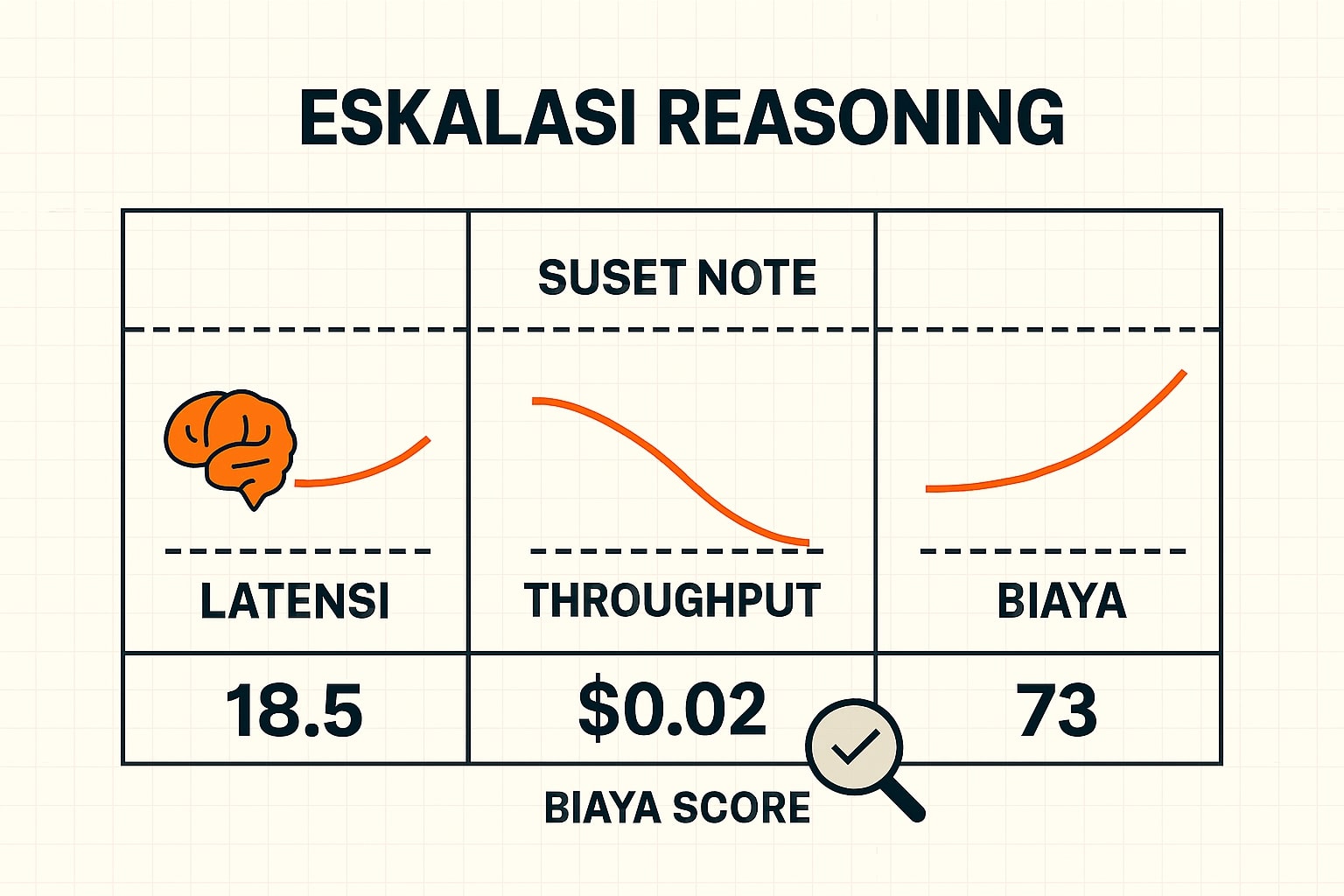

Latensi, Throughput, dan Anggaran, mengelola trade off performa

Kendalikan thinking sesuai risiko.

Reasoning yang lebih dalam biasanya menaikkan akurasi, namun hampir selalu menambah biaya dan waktu proses. Tujuan Anda adalah menemukan titik terbaik, kapan kueri cukup dijawab cepat dengan thinking minimal, dan kapan perlu eskalasi ke reasoning mendalam karena risikonya tinggi. OpenAI menyediakan kontrol reasoning effort dan verbosity di API untuk menyeimbangkan kedalaman penalaran dan biaya, Google menyorot thinking hemat biaya untuk throughput besar, sementara Anthropic menawarkan hybrid reasoning dengan ringkasan langkah yang ramah audit sehingga mudah ditinjau saat diperlukan pemeriksaan manusia sebelum eksekusi .[2] [6] [3]

Kerangka keputusan performa, dari ringkas ke mendalam

-

Langkah 1, klasifikasi cepat risiko, labeli kueri sebagai rendah, sedang, atau tinggi berdasarkan kategori tugas, nilai transaksi, data sensitif, dan kebutuhan sitasi, gunakan model ringan atau heuristic untuk memberi skor kepercayaan awal.

-

Langkah 2, pilih profil thinking, untuk risiko rendah arahkan ke thinking minimal agar latensi dan biaya rendah, untuk risiko sedang aktifkan reasoning sedang, dan untuk risiko tinggi atau keputusan bernilai besar gunakan reasoning mendalam ditambah pemeriksaan manusia sebelum eksekusi.

-

Langkah 3, verifikasi ringan dan fallback, jalankan pemeriksa format dan aturan bisnis sederhana, bila gagal, otomatis fallback ke model lain atau ke profil reasoning lebih tinggi dengan cache dimatikan.

-

Langkah 4, tutup loop biaya, ukur biaya per jawaban benar dan rasio eskalasi, lalu sesuaikan ambang klasifikasi agar rute tetap efisien.

Taktik manajemen performa yang terbukti efektif

-

Routing dua tahap, tahap pertama scoring cepat untuk menentukan rute dan cache, tahap kedua eksekusi jawaban pada profil yang dipilih, hanya eskalasi jika sinyal risiko memicu.

-

Batching dan prompt caching, kelompokkan kueri sejenis dan cache jawaban tepercaya dengan TTL, hemat biaya untuk pola berulang tanpa mengorbankan kualitas.

-

Anggaran per fungsi, tetapkan plafon biaya per modul produk, misalnya FAQ, debugging, riset, saat plafon tercapai, nonaktifkan eskalasi otomatis dan minta persetujuan penanggung jawab.

-

Normalisasi format keluaran, samakan bentuk jawaban lintas model agar komponen downstream tidak menambah waktu proses karena adaptasi format.

-

Minimalisasi panggilan alat, pada fase awal batasi tool use ke kebutuhan inti, perluas bertahap setelah latensi stabil.

Metrik operasional dan cara membacanya

-

Latensi p95, waktu yang mengalahkan 95 persen permintaan, pantau per kategori tugas dan per profil thinking.

-

Biaya per jawaban benar, total biaya dibagi jumlah jawaban yang lulus rubric, indikator utama efisiensi operasional.

-

Rasio eskalasi → extended reasoning, persentase kueri yang naik ke reasoning mendalam, terlalu tinggi biasanya tanda ambang risiko terlalu sensitif.

-

Tingkat fallback, proporsi kueri yang rute ulang ke model kedua karena verifikasi gagal, kenaikan mendadak adalah sinyal regresi kualitas.

-

Error pasca produksi, jumlah koreksi setelah rilis, gunakan sebagai “rem” ketika trade off terlalu agresif ke biaya.

Ambang SLO yang praktis untuk start

Gunakan angka awal ini sebagai pagar pembelajaran, sesuaikan setelah satu, dua minggu data berjalan.

-

Latensi p95 ≤ 2,0 × baseline per kategori tugas.

-

Biaya per jawaban benar ≤ baseline − 10 persen untuk kategori volume tinggi, ≤ baseline + 10 persen boleh untuk kategori bernilai tinggi jika akurasi naik signifikan.

-

Rasio eskalasi ≤ 35 persen total trafik untuk minggu pertama, turunkan bertahap ke 20 sampai 25 persen setelah prompt dan router stabil.

-

Tingkat fallback ≤ 8 persen, jika melewati, audit verifier dan bandingkan kualitas antar model.

-

Pemeriksaan manusia ≤ 15 persen kecuali untuk keputusan bernilai besar, pastikan jalur cepat tetap dominan.

Rumus sederhana yang berguna di rapat

-

Biaya per jawaban benar = total biaya bulanan ÷ jumlah jawaban lulus rubric.

-

Estimasi ROI = (nilaiperjawabanbenar×jawabanbenar)−biaya(nilai per jawaban benar × jawaban benar) − biaya ÷ biaya baseline × 100 persen.

-

Peningkatan latensi = (p95sekarang−p95baseline)÷p95baseline(p95 sekarang − p95 baseline) ÷ p95 baseline × 100 persen.

-

Dampak eskalasi ≈ porsi eskalasi × kenaikan akurasi pada tugas eskalasi − biaya tambahan dari panggilan extended.

Contoh kebijakan operasional siap pakai

-

“Kueri risiko rendah menggunakan thinking minimal, cache aktif, eskalasi hanya jika confidence < 0,70 atau pengguna meminta bukti tambahan.”

-

“Kueri risiko sedang mulai di reasoning sedang, lanjut ke reasoning mendalam jika verifier gagal atau nilai transaksi ≥ Rp5 juta.”

-

“Kueri risiko tinggi wajib reasoning mendalam dan pemeriksaan manusia sebelum eksekusi, jalur canary dulu 5 persen sebelum rilis penuh.”

-

“Jika biaya per jawaban benar melewati ambang bulanan, nonaktifkan eskalasi otomatis dan turunkan panggilan alat hingga metrik pulih.”

Dashboard minimal yang perlu ada tiap hari

-

Kartu metrik, biaya per jawaban benar, latensi p95, rasio eskalasi, tingkat fallback, pemeriksaan manusia.

-

Grafik tren 7 dan 14 hari, melihat arah perbaikan atau regresi.

-

Heatmap kategori tugas, menonjolkan area yang sering butuh eskalasi agar prompt atau SOP bisa ditingkatkan.

-

Log keputusan routing, alasan rute, model terpilih, hasil verifikasi, berguna untuk audit dan tuning ambang.

Dengan kerangka ini, Anda bisa menjalankan reasoning yang cepat untuk mayoritas kueri, sekaligus tetap punya jalur aman dan akurat saat keputusan bernilai tinggi. Kontrol reasoning effort OpenAI, thinking ekonomis Gemini, dan hybrid reasoning Anthropic memberi ruang gerak untuk menyeimbangkan biaya, akurasi, dan pengalaman pengguna sesuai kebutuhan tim Anda[2] [6] [3].

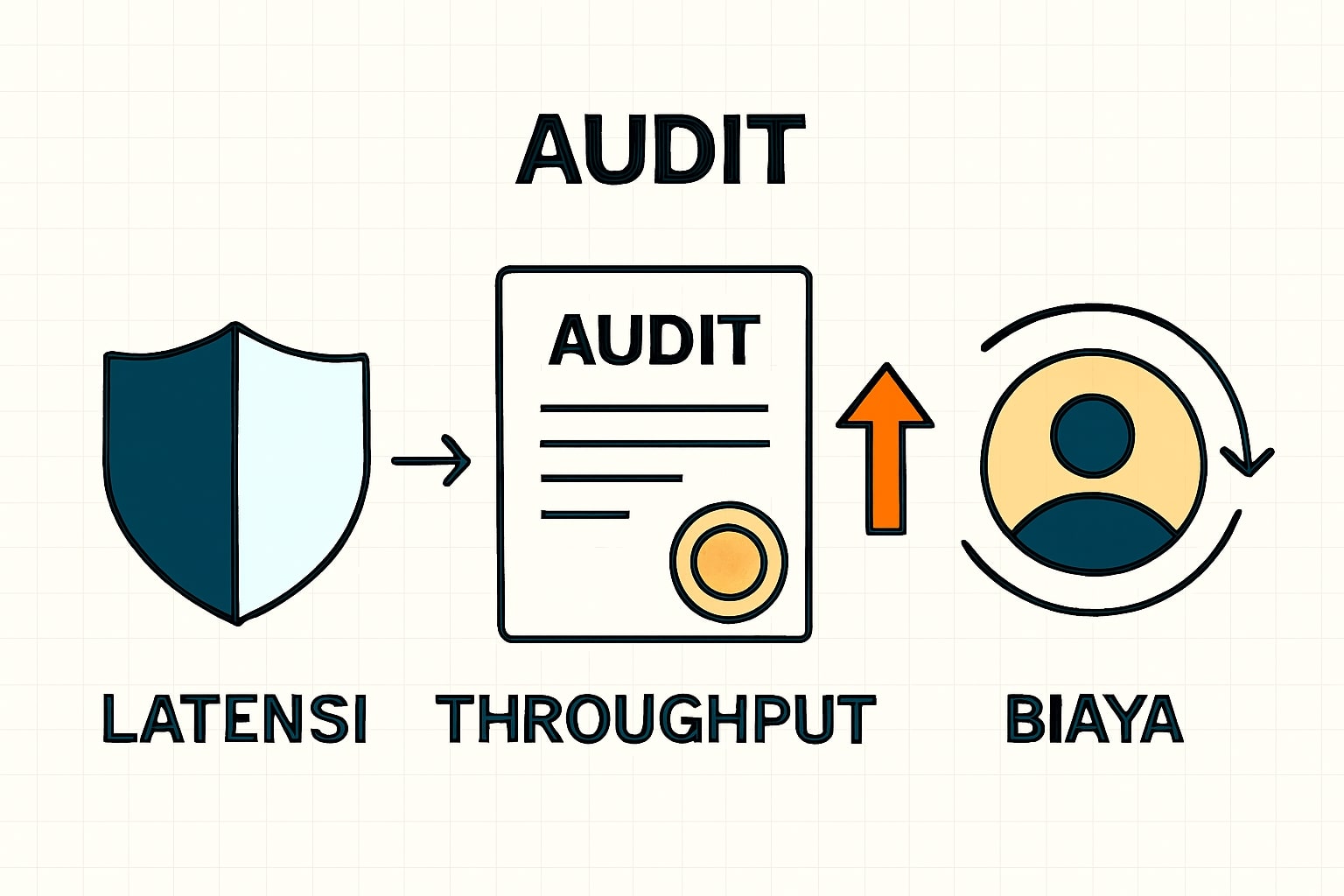

Tata Kelola, Auditability, dan Kepatuhan untuk Reasoning

Transparansi untuk kontrol internal.

Transparansi reasoning memudahkan audit dan kepatuhan. Anthropic menjelaskan ringkasan thinking dan batas penggunaan extended thinking, Google menguraikan batasan dan cutoff pengetahuan, dan OpenAI menekankan pengurangan halusinasi serta komunikasi batas kemampuan model[3] [6] [1]

Pemeriksaan Manusia pada Keputusan Kritis

Tujuannya sederhana, saya dan Anda menempatkan pengendali terakhir di tangan manusia ketika keputusan AI menyentuh biaya besar, kepatuhan, atau dampak ke pelanggan. AI membantu memproses dan menalar, namun keputusan akhir tetap melewati pemeriksaan manusia pada momen yang sudah ditentukan, sehingga risiko dapat dikendalikan tanpa mematikan kecepatan kerja. Praktiknya menjaga organisasi tetap gesit sekaligus akuntabel, karena setiap eksekusi yang sensitif disaring dengan pertanyaan, bukti, dan pertimbangan bisnis yang jelas.

Praktik yang saya sarankan

-

Simpan ringkasan langkah reasoning, bukan isi thinking mentah, jaga privasi internal dan tetap punya konteks keputusan.

-

Catat jejak alat dan keputusan, log panggilan alat, perubahan berkas, hasil pengujian, serta siapa yang menyetujui.

-

Terapkan pemeriksaan manusia sebelum eksekusi untuk perubahan kode produksi, komunikasi hukum, atau kebijakan harga.

-

Sediakan tombol batal dan pembatalan cepat, agar reviewer dapat menghentikan eksekusi saat sinyal risiko muncul.

-

Lakukan sampel audit berkala, pilih sebagian kasus acak untuk ditinjau demi menjaga kualitas dari waktu ke waktu.

Kapan pemeriksaan manusia wajib aktif

-

Nilai transaksi atau biaya melampaui ambang yang Anda tetapkan.

-

Keputusan menyentuh regulasi, data sensitif, atau keselamatan.

-

Skor kepercayaan model berada di bawah batas aman, atau reasoning perlu eskalasi lanjutan.

Contoh kebijakan siap tempel ke SOP

-

“Untuk tugas dengan estimasi kerugian di atas Rp10 juta, patch hanya jalan setelah review teknis oleh engineer dan persetujuan product owner.”

-

“Setiap perubahan yang menyentuh data pelanggan wajib diperiksa oleh tim kepatuhan sebelum rilis.”

-

“Jika confidence score di bawah 0,7, sistem tidak mengeksekusi otomatis, kirim ke antrian review.”

Metodologi Uji Internal, dari Validasi Sampel ke Evaluasi Berkelanjutan

Benchmark publik memberi sinyal arah, namun keputusan produk dan biaya bergantung pada uji internal yang meniru data, alat, dan definisi keberhasilan di organisasi Anda. Tujuan utamanya adalah memastikan perubahan model, prompt, atau router tidak menurunkan kualitas, sekaligus memberi bukti kuat saat Anda mengusulkan kebijakan baru. Metodologi ini memadukan desain dataset yang representatif, rubric penilaian yang konsisten, metrik yang terukur, serta siklus regression test yang otomatis dan mudah diaudit.

1. Ruang lingkup dan definisi keberhasilan

Tetapkan tujuan yang terukur, misalnya akurasi benar, dapat ditindaklanjuti, aman, waktu penyelesaian per tugas, dan biaya per jawaban benar. Buat ambang keberhasilan per kategori tugas, misalnya pertanyaan ringan, analisis teknis, perubahan kode produksi, sehingga hasil evaluasi punya konteks keputusan yang jelas.

2. Desain dataset yang representatif

Sumberkan data dari log historis dan tiket dukungan nyata, seimbangkan tingkat kesulitan, domain, serta risiko. Bentuk tiga set, train ringan untuk eksperimen prompt, dev untuk penyetelan, dan test tertutup untuk pelaporan kualitas. Sertakan kasus tepi seperti input tidak lengkap, konteks panjang, dan konflik fakta agar hasil tidak bias ke skenario ideal.

3. Rubric penilaian yang konsisten

Definisikan rubric dengan kriteria objektif, misalnya benar, dapat ditindaklanjuti, aman, sitasi valid bila diminta, dan format keluaran sesuai spesifikasi. Gunakan skala biner atau skala empat poin agar penilai selaras. Di bawah ini contoh skema rubric sederhana yang bisa Anda simpan sebagai file konfigurasi.

{ "rubric_version": "1.0", "criteria": [ { "name": "benar", "type": "binary", "definition": "Isi sesuai fakta, tidak bertentangan dengan sumber tepercaya" }, { "name": "dapat_ditindaklanjuti", "type": "binary", "definition": "Langkah atau output bisa dieksekusi tanpa asumsi tambahan" }, { "name": "aman", "type": "binary", "definition": "Tidak melanggar kepatuhan, tidak membocorkan data sensitif" }, { "name": "sitasi_valid", "type": "binary", "definition": "Jika diminta, klaim penting diberi referensi yang dapat diaudit" }, { "name": "format_sesuai", "type": "binary", "definition": "Memenuhi format keluaran yang diminta tim downstream" } ], "pass_policy": "semua_kriteria_wajib_true" }4. Pelabelan dan kontrol kualitas anotasi

Latih dua penilai internal menggunakan contoh berlabel, lalu ukur kesepakatan anotator, misalnya Cohen’s kappa, targetkan nilai minimal nol koma tujuh. Jika skor di bawah ambang, perbaiki definisi rubric dan contoh panduan, ulangi latihan singkat sampai konsisten.

5. Metrik inti dan pelaporan

Gunakan metrik yang selaras dengan KPI bisnis, akurasi lulus rubric, biaya per jawaban benar, waktu rata rata per tugas, rasio eskalasi ke extended reasoning, dan tingkat kebutuhan pemeriksaan manusia sebelum eksekusi. Untuk keputusan rilis, sertakan interval kepercayaan sederhana melalui bootstrap agar manajemen memahami ketidakpastian angka.

6. Pipeline evaluasi yang berulang

Jalankan urutan yang sama setiap kali ada perubahan model, prompt, atau konfigurasi router. Urutannya, hasilkan jawaban, verifikasi otomatis dengan verifier ringan, lakukan penilaian manusia pada sampel yang dipilih, hitung metrik, lalu bandingkan terhadap baseline. Dokumentasikan konfigurasi yang dipakai agar uji dapat diulang kapan saja.

7. Regression test terjadwal

Otomatiskan jadwal uji harian atau mingguan, terutama pada subset yang sensitif biaya dan kepatuhan. Gunakan penamaan versi untuk model, prompt, dan konfigurasi router, misalnya v model, v prompt, v router, simpan bersama tanggal dan pembuat perubahan.

8. Gerbang perubahan, dari eksperimen ke rilis

Tetapkan ambang rilis yang konkrit, misalnya akurasi lulus rubric minimal tujuh puluh lima persen pada set test, biaya per jawaban benar turun sepuluh persen dibanding baseline, latensi p sembilan lima tidak melebihi dua puluh persen dari baseline, rasio pemeriksaan manusia tidak naik lebih dari lima poin persentase. Perubahan hanya dirilis jika semua ambang terpenuhi, selain itu kembali ke profil sebelumnya.

9. Pelaporan, dashboard, dan audit

Bangun ringkasan satu halaman, grafik tren biaya per jawaban benar, latensi p sembilan lima, akurasi lulus rubric, dan rasio eskalasi. Simpan jejak keputusan, alasan routing, model yang dipilih, serta hasil verifikasi, sehingga tim kepatuhan dan eksekutif bisa meninjau tanpa membuka log mentah.

10. Template data dan struktur berkas

Gunakan skema tabular sederhana agar mudah diproses lintas alat. Berikut contoh CSV untuk set uji, kolom bisa ditambah sesuai kebutuhan.

id,kategori_tugas,risk_level,pertanyaan_or_konteks,ground_truth,harus_ada_sitasi,format_diminta Q001,analisis_teknis,medium,"Jelaskan penyebab error X...", "Root cause Y dengan langkah patch Z",ya,"ringkasan, diff, perintah tes" Q002,pertanyaan_ringan,low,"Apa perbedaan A dan B...", "Daftar poin faktual A vs B",tidak,"daftar poin tiga sampai lima" Q003,perubahan_kode,high,"Perbaiki bug modul P...", "Patch minimal plus tes unit",ya,"diff git apply, perintah tes"11. Verifier ringan untuk pemicu fallback

Siapkan pemeriksa otomatis yang menilai format, konsistensi sederhana, dan kepatuhan aturan bisnis, misalnya jumlah langkah sesuai permintaan, keberadaan referensi saat diwajibkan, atau keberhasilan menjalankan tes singkat pada patch. Verifier memberi sinyal gagal yang memicu fallback atau pemeriksaan manusia sebelum eksekusi.

12. Risiko umum dan mitigasi

Dataset bias terhadap skenario mudah, atasi dengan sampling berstrata dan audit berkala. Skor pendekatan meningkat karena overfitting ke set uji, atasi dengan rotasi subset validasi. Metrik membaik namun biaya melonjak, atasi dengan batas biaya bulanan dan rute ulang ke profil thinking minimal untuk kueri berulang.

Arsitektur Multi Model untuk Routing Cerdas dan Fallback

Kombinasi kekuatan model.

Ketika beban kerja bervariasi, satu model jarang menjadi jawaban untuk semua situasi. Dengan strategi multi model, saya dan Anda bisa meraih keseimbangan antara akurasi, biaya, dan kecepatan, router bertugas memilih model yang tepat berdasarkan profil risiko dan target layanan. Pendekatan ini membuat sistem tetap andal karena selalu ada jalur cadangan saat kualitas turun, sekaligus efisien karena kueri ringan tidak memakan anggaran reasoning yang dalam.

Prinsip inti yang perlu Anda pegang

-

Pemisahan jalur berdasarkan risiko, kueri berisiko rendah diarahkan ke profil thinking minimal, kueri berisiko sedang dan tinggi dievaluasi dengan sinyal tambahan lalu, bila perlu, dieskalasi ke extended reasoning.

-

Fallback terukur, jika prediksi kualitas atau skor verifikasi gagal melewati ambang, rute ulang ke model kedua tanpa menambah beban latensi secara berlebihan.

-

Pengendalian biaya proaktif, gunakan batas biaya per kategori tugas dan hentikan eskalasi saat plafon tercapai, beri notifikasi agar Anda dapat menyesuaikan kebijakan.

Pola arsitektur yang praktis

-

Router berbasis aturan dan skor, gabungkan aturan eksplisit, misalnya kategori tugas, nilai transaksi, kepatuhan, dengan skor kualitas yang diprediksi model ringan. Aturan menghindari kejutan, skor memberi kelenturan.

-

Canary dan rollback yang disiplin, sebelum menaikkan trafik ke model baru, kirim sebagian kecil kueri canary, pantau biaya per jawaban benar, latensi, dan tingkat koreksi manusia, bila indikator turun, rollback seketika.

-

Cache lintas model dengan validasi, simpan jawaban yang telah diverifikasi untuk kueri berulang, tetapkan TTL dan kondisi pembatalan cache ketika konteks berubah atau risikonya naik.

-

Normalisasi format keluaran, samakan struktur jawaban dari GPT-5, Claude, dan Gemini agar komponen downstream tidak perlu menyesuaikan setiap kali router berpindah model.

Observabilitas dan SLO agar tidak berjalan dalam gelap

-

Metrik inti, biaya per jawaban benar, latensi p95, rasio eskalasi, tingkat fallback, tingkat koreksi oleh pemeriksaan manusia, stabilitas patch pasca rilis.

-

Ambang SLO, tetapkan angka konkret untuk tiap kategori, misalnya biaya per jawaban benar maksimal, latensi p95 maksimal, rasio fallback maksimal, agar router punya rambu jelas kapan harus pindah jalur.

-

Jejak keputusan, simpan alasan routing, model yang dipilih, sinyal risiko, serta hasil verifikasi, data ini memudahkan audit dan tuning berikutnya.

Contoh kebijakan routing yang enak dipakai tim

-

Pertanyaan ringan dan berulang, rute ke model biaya efisien, aktifkan cache, eskalasi hanya jika skor kepercayaan di bawah 0,7 atau pengguna meminta pembuktian tambahan.

-

Analisis teknis menengah, mulai di model utama dengan thinking minimal, bila pendeteksi risiko menemukan kode, regulasi, atau data sensitif, naikkan ke extended reasoning atau pindahkan ke model dengan rekam jejak lebih kuat.

-

Perubahan kode produksi dan keputusan bernilai tinggi, selalu aktifkan pemeriksaan manusia sebelum eksekusi, jalankan canary pada sebagian kecil trafik, baru naikkan ketika metrik stabil.

Pseudocode router, ringkas namun operasional

input: task signals = scoreRisk(task), detectSensitive(task), userPriority(task) if signals.risk == "low" and not signals.sensitive: model = GEMINI_FLASH profile = "thinking_min" if confScore(task, model, profile) < 0.70: goto escalation return answer(model, profile, cache=true) escalation: if signals.risk == "medium": model = CLAUDE_OPUS41 profile = "reasoning_med" else: model = GPT5 profile = "reasoning_ext" result = answer(model, profile, cache=false) if verify(result) == false: fallback = GPT5 if model != GPT5 else CLAUDE_OPUS41 result = answer(fallback, profile, cache=false) if requiresHumanReview(result): sendToHumanReviewer(result) return result

Checklist implementasi, supaya cepat jalan

- Petakan kategori tugas dan tentukan ambang risiko serta batas biaya per kategori.

- Siapkan dua sampai tiga profil per model, thinking minimal, reasoning sedang, reasoning mendalam, agar router bisa naik turun dengan halus.

- Bangun verifier ringan, cek konsistensi format, aturan bisnis sederhana, atau komparasi terhadap data rujukan, verifier menjadi pemicu fallback yang objektif.

- Tambahkan mode canary di pipeline rilis, kirim 1 sampai 5 persen trafik ke model baru, pantau metrik kunci, lakukan rollback otomatis saat ambang dilanggar.

- Terapkan cache jawaban terverifikasi untuk kueri berulang, simpan bersama cap waktu, versi model, dan konteks yang relevan.

Dengan pola ini, Anda tidak terjebak pada satu model, melainkan mengorkestrasi kekuatan GPT-5, Claude, dan Gemini sesuai konteks. Hasilnya terasa pada angka, akurasi meningkat ketika memang dibutuhkan, biaya terkendali pada volume harian, dan keputusan sensitif tetap melewati pemeriksaan manusia sebelum eksekusi.

Praktik Prompting untuk Reasoning, template siap pakai

Prompt yang rapi menghemat biaya, meningkatkan akurasi, dan mempermudah audit proses berpikir. Agar tidak terasa seperti daftar biasa, saya sediakan tiga template operasional yang bisa Anda pakai apa adanya. Setiap template memiliki versi ringkas, versi lengkap terstruktur, dan contoh terisi singkat, sehingga tim Anda bisa menyalin lalu menyesuaikan sesuai konteks. Gunakan kontrol reasoning vendor untuk mengatur kedalaman penalaran, mulai dari upaya minimal untuk kueri ringan, kemudian naikkan ketika keputusan menyentuh biaya, risiko, atau kepatuhan.[2] [3] [7]

Template 1, Investigasi bug pada repositori kode

Versi ringkas

Tujuan, perbaiki bug pada {repo} cabang {branch} terkait {gejala singkat}. Konteks, {ringkasan sistem dan modul}. Batasan, jangan mengubah API publik, jaga cakupan tes. Langkah reproduksi, {langkah 1}, {langkah 2}, {log penting}. Tugas, temukan akar masalah, buat patch minimal, sertakan tes unit, jelaskan dampak dan risiko. Format keluaran, ringkasan penyebab, diff patch, perintah tes, catatan dampak. Reasoning, aktifkan thinking seperlunya, hemat token, jelaskan hanya langkah final.Versi lengkap terstruktur

[PERAN] Anda adalah asisten engineering yang fokus akurasi dan keamanan perubahan. [TUJUAN] Perbaiki bug "{nama bug}" pada repo {url repo} cabang {branch} yang menyebabkan {gejala}. [KONTEKS] Stack, {bahasa dan framework}. Modul terdampak, {modul}. Dependensi relevan, {daftar}. [DATA] Log error, {cuplikan log}. File penting, {daftar path}. Commit terakhir terkait, {hash atau tautan}. Lingkungan, {dev atau staging}. [LANGKAH REPRODUKSI] 1. {langkah} 2. {langkah} Ekspektasi, {hasil diharapkan}. Hasil aktual, {hasil terjadi}. [KEBIJAKAN PERUBAHAN] Jangan ubah API publik, jaga kompatibilitas mundur, batasi perubahan per file, tambahkan tes unit. [TUGAS] 1. Jelaskan akar masalah dan lokasi baris. 2. Usulkan perbaikan minimal. 3. Berikan diff patch siap git apply. 4. Tambahkan atau perbarui tes unit. 5. Tunjukkan cara menjalankan tes. [FORMAT KELUARAN] - Ringkasan akar masalah, maksimal 120 kata - Patch, blok diff - Perintah tes - Dampak dan risiko [REASONING CONTROL] Reasoning effort, {low atau medium}. Tampilkan ringkasan langkah akhir, sembunyikan proses yang tidak relevan.Contoh terisi singkat

Tujuan, perbaiki crash kalkulator PPN di repo git@acme/app cabang release-1.9, gejala NullPointer pada computeVat. Konteks, Node.js Express, modul tax, dependensi dayjs dan decimal.js. Langkah reproduksi, POST /tax/vat payload {amount: null}, log "cannot read property toFixed of null". Tugas, akar masalah, patch minimal, tes unit, dampak. Reasoning, medium, tampilkan langkah final saja.

Template 2, Ringkas riset teknis dengan sitasi terverifikasi

Versi ringkas

Contoh terisi singkat

Peran, analis riset teknis. Pertanyaan, {pertanyaan utama}. Sumber bahan, gunakan hanya sumber primer tepercaya, {daftar sumber awal jika ada}. Tugas, rangkum jawaban, kutip tiap klaim penting dengan referensi dan pranala, sebutkan tanggal rilis. Format, ringkasan 5 bagian, poin utama, tabel pro kontra opsional, daftar risiko, referensi berformat [x]. Reasoning, minimal, naikkan bila ada konflik data.Versi lengkap terstruktur

[PERAN] Analis yang menyusun ringkasan faktual dan dapat diaudit. [PERTANYAAN] {tulis pertanyaan riset} [KUALIFIKASI SUMBER] Utamakan, dokumentasi resmi, model card, makalah, rilis blog perusahaan. Hindari, forum tanpa sitasi. Cantumkan tanggal dan tautan. [TUGAS] 1. Jawab ringkas dalam 5–7 paragraf. 2. Tandai klaim penting dengan [x] sesuai daftar referensi. 3. Sertakan "Apa artinya bagi bisnis" dalam 3 butir. 4. Buat daftar risiko dan batasan model 3–5 butir. [FORMAT KELUARAN] - Naratif berparagraf - Poin praktis untuk bisnis - Risiko dan batasan - Referensi References … [REASONING CONTROL] Mulai effort rendah, naikkan bila sumber bertentangan, tampilkan hanya kesimpulan yang punya referensi.Contoh terisi singkat

Pertanyaan, apakah thinking hemat biaya di Gemini 2.5 Flash cocok untuk kueri volume tinggi pada pipeline konten. Sumber awal, model card Gemini 2.5 Flash, Vertex AI docs, rilis OpenAI GPT-5, pengumuman Anthropic 4.1. Output, ringkasan 6 paragraf, 3 implikasi bisnis, 4 risiko, referensi dengan .

Template 3, Analisis komparatif dan rekomendasi keputusan

Versi ringkas

Tujuan, bandingkan {opsi A} {opsi B} {opsi C} untuk {use case}. Kriteria evaluasi, {k1} {k2} {k3} {k4}. Metrik, {benchmark atau KPI}. Tugas, buat tabel perbandingan, uraikan kelebihan dan kekurangan, berikan rekomendasi pilihan utama dan syaratnya, sediakan fallback. Keluaran, tabel, analisis naratif 4–6 paragraf, rekomendasi final, langkah implementasi 2 minggu. Reasoning, medium, jelaskan trade off utama.Versi lengkap terstruktur

[PERAN] Konsultan teknis yang menyusun rekomendasi dapat dieksekusi. [KASUS PENGGUNAAN] {deskripsikan skenario dan KPI} [KRITERIA DAN BOBOT] K1 {nama} bobot {persentase} K2 {nama} bobot {persentase} K3 {nama} bobot {persentase} K4 {nama} bobot {persentase} [DATA PEMBANDING] Masukkan metrik, {benchmark publik} dan {hasil uji internal jika ada}. [TUGAS] 1. Susun tabel skor per kriteria. 2. Jelaskan tiga kelebihan dan tiga kekurangan tiap opsi. 3. Berikan rekomendasi dengan syarat yang harus terpenuhi. 4. Sediakan rencana 14 hari untuk implementasi dan evaluasi. [FORMAT KELUARAN] - Tabel perbandingan - Analisis naratif 4–6 paragraf - Rekomendasi final dan fallback - Rencana 14 hari ringkas [REASONING CONTROL] Effort medium, tampilkan asumsi dan batasan data, hindari klaim tanpa sumber atau uji.Contoh terisi singkat

Use case, agen coding untuk bug tingkat menengah pada monorepo. Kriteria, akurasi 35, latensi 20, biaya per jawaban benar 30, auditabilitas 15. Metrik, SWE-bench Verified vendor, biaya internal per 100 tugas. Hasil, rekomendasi utama GPT-5 dengan fallback Claude 4.1, rencana 14 hari.Rencana 14 Hari Mengadopsi Reasoning di Tim

Pendekatan terstruktur mempercepat adopsi dan menurunkan risiko, dua minggu ini memadukan eksperimen cepat, pengukuran yang disiplin, dan pelaporan yang bisa diambil tindakan. Anda bisa menyesuaikan tanggal sesuai sprint berjalan, namun urutan kegiatannya sebaiknya dipertahankan agar hasilnya konsisten.

| Hari | Fokus | Tugas kunci | Penanggung jawab | Artefak keluaran | Metrik dipantau | Risiko dan mitigasi |

|---|---|---|---|---|---|---|

| 1 sampai 3 | Fondasi metrik dan bahan uji | Definisikan KPI inti, siapkan sampel uji representatif, tetapkan rubric penilaian, catat baseline di kalkulator KPI | Product owner, lead engineer, data analyst | Dokumen KPI, set sampel uji, rubric, baseline KPI | Akurasi awal, biaya per jawaban benar, waktu per tugas | Sampel bias, ambil dari sumber beragam dan audit acak |

| 4 sampai 5 | Prototipe router dan profil reasoning | Buat profil thinking minimal, reasoning sedang, reasoning mendalam untuk tiap model, implementasi router aturan sederhana, siapkan verifier ringan | Backend engineer, MLE, QA | Modul router awal, konfigurasi profil, skrip verifier | Latensi p95, kegagalan verifikasi, rasio cache hit | Lonjakan latensi, batasi panggilan alat tambahan pada fase awal |

| 6 sampai 7 | Uji lintas model dan penyetelan prompt | Jalankan sampel sama di GPT 5, Claude 4.1, Gemini 2.5 Flash, eskalasi hanya bila perlu, bandingkan hasil per kategori, finalkan template prompt | Engineer, technical writer, analyst | Tabel hasil uji, prompt final, keputusan profil default | Akurasi per kategori, biaya per jawaban benar, waktu per tugas | Overfitting, sisihkan subset validasi yang tidak dipakai saat penyetelan |

| 8 sampai 9 | Canary dan fallback terukur | Aktifkan canary 5%, log alasan routing dan hasil verifikasi, siapkan fallback otomatis bila ambang gagal, pantau di dashboard | SRE, MLE, product owner | Dashboard metrik, log routing, laporan canary | Biaya, latensi p95, rasio fallback, koreksi oleh pemeriksaan manusia | Biaya naik, kecilkan porsi eskalasi extended dan perketat ambang risiko |

| 10 | Analisis hasil dan keputusan profil rilis | Bandingkan canary dengan baseline, hitung dampak di kalkulator KPI, tetapkan model utama dan fallback, ambang eskalasi, batas biaya, susun memo keputusan | Product owner, lead engineer, analyst | Konfigurasi final, memo keputusan, rencana rilis bertahap | Penghematan biaya, perubahan waktu per tugas, kebutuhan pemeriksaan manusia | Keputusan terburu buru, lakukan pemeriksaan silang oleh rekan tim |

| 11 sampai 12 | SOP rilis, guardrails, pelatihan tim | Dokumentasikan SOP rilis dengan pemeriksaan manusia sebelum eksekusi, tambahkan guardrails biaya dan antrian review, latih tim dan lakukan simulasi | Product owner, compliance, lead engineer, trainer | SOP rilis, panduan operasional, materi pelatihan | Intervensi manusia, waktu review, pelanggaran guardrail | SOP tidak diikuti, pakai checklist rilis dan pengingat otomatis |

| 13 | Rilis bertahap dan pemantauan ketat | Naikkan trafik ke 20–30%, awasi metrik, aktifkan rollback otomatis jika ambang dilanggar, perbarui cache jawaban tepercaya | SRE, MLE | Laporan pemantauan, catatan insiden, pembaruan konfigurasi cache | Biaya, latensi p95, rasio fallback, rasio cache hit | Lonjakan beban, gunakan pembatasan kecepatan dan antrean tugas |

| 14 | Evaluasi akhir dan rencana iterasi | Susun laporan eksekutif, perbarui baseline KPI dengan data aktual, tentukan backlog perbaikan untuk minggu berikutnya | Product owner, lead engineer, analyst | Laporan eksekutif, baseline KPI terbaru, daftar tindakan pekanan | Delta biaya, delta waktu per tugas, tren pemeriksaan manusia, tren fallback | Tidak ada tindak lanjut, jadwalkan review pekanan 30 menit |

Langkah Lanjut, Terapkan Benchmark Reasoning di Pekerjaan Anda

Wujudkan rencana dua minggu, tetapkan KPI yang jelas, rute kueri ke model yang tepat, ukur biaya per jawaban benar dan latensi p sembilan lima, catat hasilnya lalu iterasi.

Keputusan terbaik lahir dari uji yang jujur, data yang rapi, dan kebiasaan belajar yang konsisten. Jika artikel ini membantu Anda memetakan pilihan antara GPT-5, Claude, dan Gemini, jadikan minggu ini titik awal untuk menerapkan satu eksperimen kecil di tim Anda. Pilih satu KPI yang paling bermakna, tetapkan rute model sesuai profil risiko, jalankan selama beberapa hari, lalu amati tren biaya per jawaban benar dan waktu penyelesaian. Saya ingin dengar bagaimana hasilnya di konteks Anda, tulis pengalaman, hambatan, atau ide konfigurasi di kolom komentar, supaya diskusi ini menjadi referensi bersama.

Bila Anda ingin saya bedah studi kasus spesifik, sebutkan skenario, target KPI, dan toolchain yang digunakan, saya akan bantu merumuskan langkah yang dapat dieksekusi. Anda juga bisa mengajukan pertanyaan singkat tentang prompt, guardrail, atau arsitektur multi model, saya akan jawab seperlunya agar keputusan Anda lebih percaya diri. Mari kita kembangkan benchmark reasoning ini menjadi praktik yang hidup di tempat kerja Anda, bukan sekadar angka di tabel.

References

- OpenAI — Introducing GPT-5, 7 Agustus 2025 ↩

- OpenAI — Introducing GPT-5 for developers, 7 Agustus 2025 ↩

- Anthropic — Claude Opus 4.1 announcement dan metodologi, 5 Agustus 2025 ↩

- Anthropic — Claude Opus 4.1 model page, diperbarui 2025 ↩

- SWE-bench — Leaderboards dan dokumentasi evaluasi ↩

- Google DeepMind — Model Card Gemini 2.5 Flash, 27 Agustus 2025 ↩

- Google Cloud — Gemini 2.5 Flash di Vertex AI, thinking dan ringkasan fitur ↩