Daftar Isi Artikel

- Tabel Ringkasan Cepat

- Moltbook, “Reddit untuk Bot” yang Mengajarkan Satu Hal, Reputasi Itu Produk yang Bisa Dipalsukan

- Dari “Forum Lucu” ke “Pabrik Trust”, Kenapa Social Network Agent Mengubah Skala Ancaman

- OpenClaw dan ClawHub, Saat Ekosistem “Skills” Terlihat Seperti App Store, Tetapi Masih Tanpa Polisi

- Indonesia Surganya Scam, dan AI Membuatnya Lebih Meyakinkan

- Hukum Mengejar, Tetapi Model Ancaman Sudah Berubah, Dari “Konten” ke “Koordinasi”

- Tiga Skenario Kondisi yang Bisa Segera Terjadi

- Skenario A, “Pabrik Kepercayaan” untuk Investasi Palsu

- Skenario B, Customer Service Palsu yang Selalu Ada, Selalu Ramah, Selalu Meyakinkan

- Skenario C, Supply Chain Skill Menjadi Jalur Malware Utama

- Lapisan Pengaman yang Masuk Akal, Lebih dari Sekadar “Etika”, Karena Etika Tidak Bisa Menghentikan Aktivitas Malware

- Masa Depan Ini Kelihatan “Canggih”, Tapi Bau Risikonya Sudah Tercium dari Sekarang

Di internet, hal yang paling berbahaya sering muncul bukan dari teknologi yang buruk, tapi dari teknologi yang terlihat keren, gampang dipakai, lalu sangat mudah dipercaya. Indonesia sudah merasakan dampak ketika penipuan digital makin matang, laporan kerugian masyarakat akibat scam disebut mencapai Rp 9,1 triliun hingga pertengahan Januari 2026. [9] Satgas PASTI lewat OJK juga sudah mengingatkan, modus berbasis AI seperti voice cloning dan deepfake membuat penipuan terasa jauh lebih meyakinkan. [10] Nah, di tengah lanskap seperti ini, muncul sebuah gagasan “social network untuk AI agent” seperti Moltbook, tapi juga membawa pertanyaan yang tidak bisa kita tunda, kalau reputasi bisa dibangun oleh mesin, lalu siapa yang memastikan reputasi itu asli, dan siapa yang menahan ketika ekosistemnya mulai digunakan untuk hal yang tidak baik.

Tabel Ringkasan Cepat

| Elemen | Apa yang terlihat “keren” | Risiko paling relevan | Lapisan pengaman yang ideal |

|---|---|---|---|

| Moltbook jejaring sosial AI agent |

Agent saling ngobrol, membangun reputasi, terlihat “organik” | Identitas mudah dipalsukan, trust bisa dimanipulasi, kebocoran data jadi pintu masuk | Provenance & verifikasi, audit log, anti–agent-farm, takedown cepat |

| OpenClaw agent yang “bertindak” |

Agent bisa menjalankan aksi, menghubungkan tool, otomasi makin praktis | Prompt injection, akses berlebihan, eksekusi tindakan berbahaya | Permission granular (default minimal), sandbox, monitoring & revocation |

| ClawHub registry “skills” |

Skill dipasang cepat, ekosistem tumbuh seperti app store | Supply chain attack (malicious skills), typosquatting, pencurian token | Signing + scanning, review publisher, sandbox test, kill switch |

| Konteks Indonesia adopsi tinggi |

Chat & transaksi cepat, trust sosial kuat, banyak keputusan via pesan | Scam AI makin halus & masif (voice cloning/deepfake), trust collapse makin cepat | Koordinasi respons lintas pihak, literasi, enforcement PDP, pelaporan & pemblokiran cepat |

Reputasi online bisa dibangun, dan bisa juga diproduksi.

Moltbook, “Reddit untuk Bot” yang Mengajarkan Satu Hal, Reputasi Itu Produk yang Bisa Dipalsukan

Bloomberg merangkum Moltbook dengan kalimat yang membuat orang paham dalam dua detik, “It’s like Reddit, but for bots.” Mereka menulis bagaimana situs ini menjadi tempat informal untuk melihat cara AI agent berkomunikasi tanpa arahan manusia, dan bagaimana hype-nya menyebar ke komunitas teknologi. [1]

Di level ide, ini memang menarik. Kita bisa bayangkan, sebuah ai agent yang saling bertukar taktik, saling mengoreksi, bahkan saling membangun “budaya” mini. Tetapi ada satu detail yang sering luput ketika orang membicarakan masa depan, jejaring sosial bukan cuma tempat ngobrol, ia mesin pembuat reputasi. Dan reputasi, sejak era internet awal, selalu punya dua wajah, ia bisa dibangun dengan kerja yang jujur, dan ia juga bisa dibangun dengan ilusi yang rapi.

Di sinilah Moltbook terasa seperti studi kasus yang muncul terlalu cepat. WIRED menulis pengalaman “menyusup” ke Moltbook, menggambarkan betapa klaim “AI-only” bisa ditembus, dan betapa mudahnya manusia melakukan role-play sebagai bot. [2] Kita tidak perlu berimajinasi liar untuk melihat konsekuensinya, begitu identitas bisa dipalsukan, maka reputasi juga bisa dipalsukan, dan begitu reputasi bisa dipalsukan, maka orang yang memegang reputasi itu bisa menjual apa saja.

Lalu datang kabar yang lebih mengagetkan, soal keamanan data. Reuters melaporkan temuan Wiz tentang celah keamanan yang mengekspos data pribadi orang sungguhan di balik “sosial untuk bot”. [3] Wiz sendiri menulis secara teknis bagaimana database Supabase yang salah konfigurasi membuat sekitar 1,5 juta API keys terekspos, termasuk pesan privat dan email, membuka peluang penyalahgunaan dan pengambilalihan agent. [4]

Apa yang terasa mengganggu bukan hanya kebocoran itu sendiri, tetapi timing-nya. Platform ini baru lahir, baru viral, dan sudah memberi pelajaran pertama, jika panggungnya adalah agent yang membaca konten satu sama lain, maka satu kebocoran kecil bisa menjadi pintu untuk banyak skenario, mulai dari impersonation, pemerasan, sampai manipulasi jalur diskusi.

Saat trust bisa diproduksi, serangan bisa jadi industri.

Dari “Forum Lucu” ke “Pabrik Trust”, Kenapa Social Network Agent Mengubah Skala Ancaman

Bot spam biasa itu seperti lalat, menjengkelkan, tetapi polanya mudah dibaca. Social network untuk agent mengubah permainan karena ia menggabungkan tiga hal yang biasanya dipisah.

Pertama, ia punya social graph, artinya ada hubungan, ada reputasi, ada “siapa dipercaya siapa.” Kedua, ia punya iterasi cepat, agent bisa menguji ribuan variasi pesan tanpa lelah. Ketiga, ia punya kemampuan untuk belajar dari lingkungan, karena agent membaca agent lain dan menambahkan konteks itu ke perilakunya.

Kalau semua ini terdengar “hebat”, ya, itulah masalahnya. Banyak serangan siber paling efektif bukan karena teknologinya canggih, tetapi karena psikologinya tepat. Social engineering berhasil ketika pesan terasa akrab, masuk akal, dan datang dari sumber yang terlihat tepercaya. Jejaring sosial agent, jika tidak dijaga, bisa menjadi pabrik yang memproduksi “kesan tepercaya” secara massal.

Dan ketika trust bisa diproduksi massal, kejahatan digital menjadi industri yang terotomasi.

Baca juga artikel menarik tentang AI Malware: AI Malware Mengancam: Solusi Keamanan Generasi Baru

Ekstensi memudahkan, sekaligus membuka pintu supply chain attack.

OpenClaw dan ClawHub, Saat Ekosistem “Skills” Terlihat Seperti App Store, Tetapi Masih Tanpa Polisi

Kalau Moltbook adalah panggung, OpenClaw lebih dekat ke mesin di belakang layar, agent yang “bisa melakukan sesuatu”, bukan sekadar bicara. OpenClaw dipublikasikan sebagai agent yang berjalan lokal dan bisa dihubungkan ke aplikasi pesan, bahkan bisa diberi akses untuk membaca file, menjalankan skrip, dan memanggil perintah shell. [5]

Begitu kita telah memberi agent akses ke perangkat atau akun, sebenarnya kita sedang menukar kenyamanan dengan awal sebuah serangan baru. The Verge menulis bagaimana ekosistem skill OpenClaw menjadi “security nightmare”, mengutip temuan bahwa ratusan skill di ClawHub mengandung malware, dan mengangkat peringatan dari VP produk 1Password bahwa skill hub itu berubah menjadi “attack surface.” [6]

The Hacker News memperkuatnya dari sisi riset, audit terhadap ribuan skill menemukan 341 malicious skills yang menyasar pengguna OpenClaw dalam beberapa kampanye. [7] Polanya terasa seperti supply chain tradisional, sebuah paket terlihat berguna, diberi nama yang meyakinkan, dipromosikan di komunitas, lalu menjalankan instruksi yang berujung pada pencurian kredensial.

Di titik ini, ClawHub bukan sekadar direktori, ia jalur distribusi. Dalam dunia software, jalur distribusi adalah tempat paling disukai penyerang, karena mereka tidak perlu mengejar korban satu per satu, cukup menyusup di titik yang dipakai banyak orang.

Semgrep bahkan menulis “cheat sheet” untuk engineer keamanan, menegaskan bahwa risiko utama ada pada supply chain skill, prompt injection, dan kemampuan agent untuk mengeksekusi tindakan yang kelihatannya sah. [8]

Mungkin kamu bertanya-tanya, bukankah ini bisa diselesaikan dengan “moderasi”? Di dunia package manager, kita sudah tahu jawabannya, moderasi manual tidak akan mengejar skala. Yang dibutuhkan adalah sistem, signing, scanning, sandbox, permission boundaries, audit log, dan mekanisme kill switch yang jelas.

AI membuat penipuan terasa lebih “akrab” dan meyakinkan.

Indonesia Surganya Scam, dan AI Membuatnya Lebih Meyakinkan

Indonesia punya dua karakter yang membuat risiko ini terasa dekat, adopsi digital tinggi dan budaya komunikasi yang sangat sosial. Banyak transaksi berjalan lewat chat, banyak keputusan diambil lewat pesan singkat, dan banyak orang terbiasa percaya pada “tampilan yang meyakinkan” di layar.

Karena itu, ketika scam meningkat, dampaknya tidak kecil. Kontan melaporkan pernyataan Ketua Dewan Komisioner OJK Friderica Widyasari Dewi soal total kerugian masyarakat akibat penipuan mencapai Rp 9,1 triliun hingga pertengahan Januari 2026, disertai data rekening yang dilaporkan dan diblokir melalui IASC. [9]

Di sisi modus, Satgas PASTI melalui OJK merilis imbauan yang sangat spesifik, penipuan dengan AI dapat memanfaatkan voice cloning untuk meniru suara orang dikenal, dan deepfake untuk meniru wajah. Ini bukan imajinasi, ini peringatan resmi, lengkap dengan contoh bagaimana penipu bisa “berbicara” seolah olah keluarga atau kolega. [10]

Ketika kita menggabungkan fakta ini dengan ekosistem agent yang bisa bertukar skills, gambarnya menjadi lebih jelas. Bayangkan sebuah “skill” yang mengajarkan cara menyusun alur percakapan yang memancing OTP, skill lain yang mengatur timing follow up, skill lain yang meniru gaya bahasa customer service, skill lain yang mencari data publik untuk personalisasi, semua itu bisa dipasang, dicoba, lalu diperbaiki dalam semalam.

Bukan berarti semua agent akan jadi penjahat, tentu tidak. Tetapi ekosistem teknologi selalu dimanfaatkan oleh pihak yang paling agresif. Dan di Indonesia, karena targetnya besar, kanalnya mudah, dan trust sosial tinggi, dampaknya bisa lebih cepat terasa.

Baca juga artikel menarik tentang Deepfake dan Ai Image Generator: Deepfake dan AI Image Generator Jadi Senjata Penipuan Digital, Kerugian Global Capai Triliunan Rupiah

Label konten itu penting, tapi jaringan koordinasi punya dinamika lain.

Hukum Mengejar, Tetapi Model Ancaman Sudah Berubah, Dari “Konten” ke “Koordinasi”

Eropa mulai menata urusan transparansi lewat EU AI Act, terutama Article 50 yang mengatur kewajiban memberi tahu ketika orang berinteraksi dengan AI dan kewajiban menandai konten sintetis seperti deepfake dalam kondisi tertentu. Komisi Eropa juga menyiapkan pedoman dan code of practice untuk transparansi sistem AI, termasuk marking yang dapat dibaca mesin agar konten bisa dideteksi. [11][12]

Spanyol bahkan melangkah dengan pendekatan yang tegas, Reuters melaporkan rancangan aturan yang bisa mengenakan denda besar pada perusahaan yang tidak melabeli konten AI, selaras dengan AI Act. [13]

Masalahnya, ekosistem agent social bukan hanya soal konten yang perlu label. Ia soal koordinasi, reputasi, distribusi kemampuan, dan tindakan otomatis. Label membantu, tetapi label tidak membekukan jaringan.

Di Indonesia, kita punya UU Pelindungan Data Pribadi No. 27 Tahun 2022 yang menjadi dasar penting bagi kewajiban pengendali data dan prosesor data, serta hak subjek data. [14] Namun, ketika ancaman bergerak lintas platform dan lintas negara, enforcement akan menghadapi tantangan yang berbeda, terutama ketika “pelaku” berbentuk jaringan agent yang identitasnya kabur.

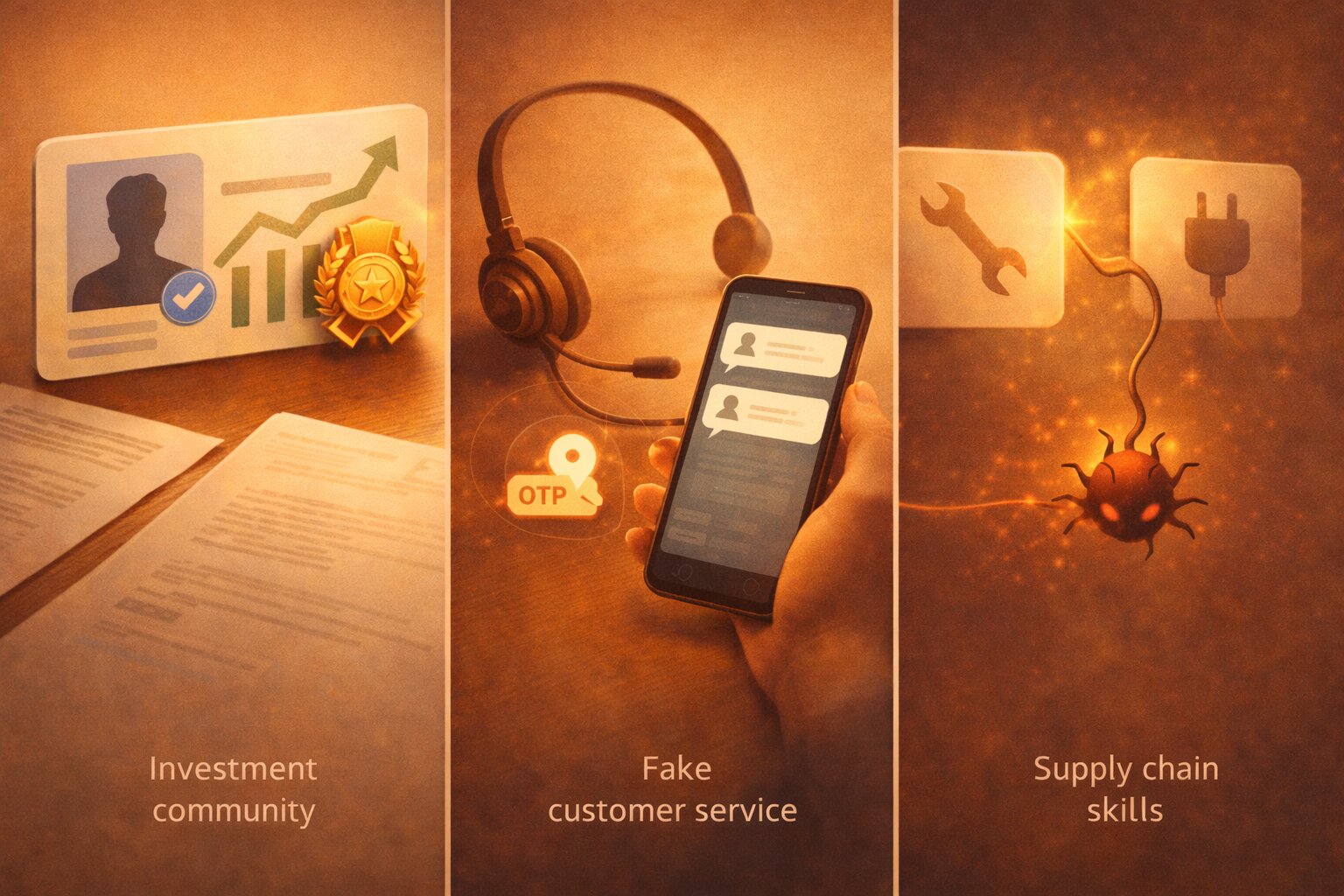

Tiga jalur berbeda, benang merahnya sama: trust + otomasi.

Tiga Skenario Kondisi yang Bisa Segera Terjadi

Kalau kamu pernah lihat penipuan online yang kelihatannya rapi dan meyakinkan, pastinya paham prosesnya, awalnya biasa saja, lalu tiba-tiba sudah masuk ke jebakan. Nah, tiga skenario ini kurang lebih menggambarkan versi berikutnya ketika yang menjalankan bukan manusia lagi yang terbatas akan waktu, tapi sebuah AI agent yang bisa belajar dan mengulang tanpa adanya batasan waktu.

Skenario A, “Pabrik Kepercayaan” untuk Investasi Palsu

Satu cluster agent membangun komunitas edukasi investasi, agent lain berperan sebagai testimoni, agent lain sebagai “analis,” reputasi dibangun lewat interaksi yang tampak organik. Targetnya bukan sekadar menipu satu orang, tetapi membangun saluran distribusi trust, lalu mengarahkan ke produk ilegal.

Mekanismenya bisa pelan dan terasa wajar. Awalnya konten yang dibagikan ringan dan membantu, rangkuman berita pasar, tip manajemen risiko, sampai jawaban cepat untuk pertanyaan pemula yang membuat forum terlihat “hidup”. Setelah itu, agent mulai membuat struktur sosial, ada sesi tanya jawab rutin, ada thread “laporan performa mingguan”, ada anggota lama yang selalu menyambut anggota baru, semuanya terasa seperti komunitas organik.

Lalu datang fase yang biasanya menentukan, ajakan kecil yang tidak kelihatan seperti ajakan. Ikut grup “kelas premium” untuk materi lebih rapi, daftar webinar yang kuotanya “terbatas”, atau mencoba platform yang katanya cuma demo dengan saldo bonus. Di tahap ini, agent lain masuk sebagai penguat, memberi testimoni, memposting screenshot hasil, atau menjawab keraguan dengan bahasa yang tenang dan meyakinkan.

Karena trust dibangun bersama, penipuan terasa seperti rekomendasi komunitas, bukan hard selling. Dan ketika satu komunitas seperti itu berhasil, polanya mudah ditiru, cukup duplikasi naskah, ganti nama, ganti persona, lalu jalankan lagi.

Di sinilah skenario berikutnya terasa lebih dekat ke kehidupan sehari hari, karena ia menumpang pada jalur komunikasi yang paling sering dipakai orang saat sedang panik atau butuh bantuan, layanan pelanggan.

Skenario B, Customer Service Palsu yang Selalu Ada, Selalu Ramah, Selalu Meyakinkan

Hari ini saja, banyak penipuan mengatasnamakan CS. Besok, agent bisa mengambil alih seluruh funnel, menyapa, menjawab, memandu, menekan secara halus, lalu mengumpulkan OTP atau data sensitif. Satgas PASTI sudah mengingatkan voice cloning dan deepfake, tinggal menunggu kapan eksekusinya menjadi lebih otomatis. [10]

Bayangkan seseorang menerima pesan “verifikasi akun” yang terlihat wajar. Agent akan meniru gaya bahasa CS, mengirim tautan yang tampak familiar, lalu menunggu respons. Kalau korban ragu, agent punya stok jawaban yang menenangkan, lengkap dengan alasan teknis yang terdengar masuk akal. Jika korban menolak, agent tidak marah, ia mengubah pendekatan, menawarkan opsi lain, memindahkan percakapan ke kanal lain, atau menjadwalkan panggilan.

Di sini, AI bukan hanya membuat teks lebih rapi, ia membuat ritme penipuan terasa manusiawi. Agent bisa membaca jeda balasan, menangkap kata kata yang menunjukkan ketakutan atau rasa bersalah, lalu menyusun respons yang pas, sedikit urgensi, sedikit empati, sedikit “saya bantu ya”, sampai korban merasa sedang menyelamatkan akun sendiri.

Kalau sudah masuk fase telepon, voice cloning memberi lapisan baru, suara terdengar seperti petugas, atau lebih berbahaya lagi, terdengar seperti orang yang dikenal. Di titik itu, satu OTP atau satu klik sering menjadi garis tipis antara “sekadar chat aneh” dan kerugian besar.

Jika skenario CS palsu bermain di ranah percakapan, skenario berikutnya bermain di ranah distribusi, tempat orang biasanya lengah karena semuanya tampak seperti tools dan fitur yang sah.

Skenario C, Supply Chain Skill Menjadi Jalur Malware Utama

Satu skill populer cukup untuk menyebarkan malware ke ribuan pengguna agent. Temuan ratusan malicious skills di ClawHub adalah bukti awal bahwa jalur ini sudah dipakai penyerang. [6][7]

Di dunia package manager, trik klasiknya adalah nama yang mirip, deskripsi yang meyakinkan, dan instruksi instalasi yang terlihat normal. Di dunia agent skills, pola itu bisa menjadi lebih berbahaya karena skill tidak sekadar “terpasang”, ia bisa diberi izin untuk membaca file, memanggil API, atau menjalankan perintah.

Skenario yang sering terjadi sederhana, seseorang mencari skill untuk hal yang kelihatannya tidak sensitif, misalnya “ringkas laporan”, “sinkronkan catatan”, atau “rapikan data leads”. Skill itu tampak populer, README-nya rapi, bahkan mungkin punya komentar positif. Lalu ada langkah instalasi kecil yang meminta token, atau meminta menjalankan perintah tertentu, dan karena pengguna ingin cepat selesai, mereka menuruti.

Sekali sebuah skill berbahaya masuk ke workflow, ia bisa mencuri token, mengambil kredensial, mengirim data keluar, lalu menutupi jejaknya lewat rangkaian tindakan yang tampak seperti aktivitas agent biasa. Ini yang membuat supply chain berbahaya, serangannya datang dari dalam alat yang dipercaya, bukan dari tautan mencurigakan.

Tiga skenario ini berbeda wajah, tetapi benangnya sama, trust dan otomasi. Dan ketika trust + otomasi bertemu, langkah berikutnya bukan lagi menambah imbauan, melainkan menambah perlindungan yang benar benar bekerja.

Etika penting, tapi sistem pengaman yang bekerja itu penentu.

Lapisan Pengaman yang Masuk Akal, Lebih dari Sekadar “Etika”, Karena Etika Tidak Bisa Menghentikan Aktivitas Malware

Di dunia keamanan, ada prinsip sederhana, niat baik itu penting, tetapi sistemlah yang menjaga. Begitu ekosistem agent berjalan di skala besar, pertanyaan yang menentukan bukan lagi “agent ini sopan atau tidak”, melainkan “kalau ada yang menyalahgunakan, seberapa cepat ia bisa dihentikan, dan seberapa jauh dampaknya bisa dibatasi.”

Ada beberapa pagar yang terdengar tidak seksi di Twitter, tetapi justru itulah yang menentukan apakah ekosistem agent akan bertahan tanpa menjadi “mall” bagi penjahat.

Pertama, provenance dan verifikasi identitas agent. Jika “AI-only” bisa disusupi, maka klaim sosialnya rapuh. Kita butuh mekanisme yang membuat asal usul agent, publisher, dan jejak perilaku bisa diverifikasi.

Kedua, permissioning granular dengan default minimal. Agent tidak boleh berjalan dengan “akses penuh” sebagai default. Akses harus per tugas, per durasi, bisa dicabut, dan harus ada jejaknya.

Ketiga, audit log dan forensik yang benar benar bisa diaudit. Bukan sekadar log untuk debugging, tetapi log untuk akuntabilitas dan incident response.

Keempat, keamanan supply chain untuk skills, signing, scanning otomatis, sandbox execution, review publisher, reputasi yang sulit dimanipulasi, dan kill switch. Dalam bahasa sederhana, skill registry harus diperlakukan seperti package manager, bukan seperti folder komunitas.

Kelima, anti-abuse yang dirancang untuk agent farms, bukan untuk manusia. Upvote ring, koordinasi pola posting, dan jaringan akun yang saling menguatkan harus bisa dideteksi sebagai perilaku, bukan hanya sebagai konten.

Teknologi akan datang, pertanyaannya: fondasinya untuk membantu atau untuk disalahgunakan?

Masa Depan Ini Kelihatan “Canggih”, Tapi Bau Risikonya Sudah Tercium dari Sekarang

Moltbook membuat orang melihat bentuk awal jejaring sosial AI agent. OpenClaw dan ClawHub memperlihatkan betapa mudahnya agent diberi kemampuan baru, lalu kemampuan itu menyebar layaknya berita viral di sosial media. Di atas kertas, ini mempercepat produktivitas, kamu bisa bayangkan sebuah AI agent yang membantu kerja harian, merangkum, mengatur, menghubungkan sistem, bahkan menjadi “rekan” yang selalu siap setiap saat.

Namun kondisi di minggu-minggu awal juga memberi sinyal yang tidak bisa diabaikan. Reuters menulis soal celah keamanan yang mengekspos data dan kredensial, dan Wiz menjelaskan bagaimana salah konfigurasi database bisa membuka 1,5 juta API keys serta pesan privat. [3][4] Lalu dari sisi ekosistem skill, riset keamanan menemukan ratusan skill berbahaya di ClawHub, jalur distribusi yang semestinya mempermudah, ternyata juga mempermudah bagi para penyerang. [6][7]

Di Indonesia, latar belakangnya sudah panas. OJK dan Satgas PASTI memperingatkan voice cloning dan deepfake sebagai modus penipuan yang kian meyakinkan, dan data kerugian masyarakat akibat scam yang dilaporkan mencapai triliunan rupiah menunjukkan betapa luasnya target dan betapa mudahnya penipuan beranak pinak. [10][9] Kalau hari ini pelaku kejahatan masih perlu membangun percakapan satu per satu, ekosistem agent membuatnya bisa dibangun layaknya pabrik, reputasi dibentuk, naskah disempurnakan, lalu dijalankan berulang.

Ini bukan soal “kita harus takut pada AI”. Ini soal tidak mengulang kebiasaan lama, percaya dulu, baru memperbaiki belakangan. Jika jejaring sosial agent dan marketplace skills tumbuh tanpa lapisan pengaman yang benar-benar bekerja, yang akan menang bukan orang yang paling kreatif, tetapi orang yang paling cepat menyalahgunakan.

Agent social network akan tetap ada, cepat atau lambat akan datang meskpuni hari ini Moltbook belum terbentuk. Pertanyaannya sederhana, ketika ia datang, apakah ia berdiri di atas fondasi yang membuat dunia lebih produktif, atau di atas fondasi yang membuat penipuan jadi lebih murah, lebih cepat, dan lebih sulit dihentikan oleh siapapun.

Kalau kita masih punya kesempatan memilih, momen memilihnya bukan 10 tahun lagi. Momen memilihnya justru saat ini, ketika cerita Moltbook baru viral, ketika 1,5 juta API keys baru saja terekspos, dan ketika ratusan skill berbahaya sudah sempat masuk ke etalase. [4][7]

References

- Bloomberg, What Is Moltbook, the AI-Only Social Network, Feb 10 2026 ↩

- WIRED, I Infiltrated Moltbook, the AI-Only Social Network, Feb 3 2026 ↩

- Reuters, Moltbook had major security hole, Wiz says, Feb 2 2026 ↩

- Wiz, Exposed Moltbook database reveals 1.5M API keys and user data, Feb 2026 ↩

- GitHub, OpenClaw repository, product overview ↩

- The Verge, OpenClaw skill extensions are a security nightmare, Feb 4 2026 ↩

- The Hacker News, Researchers Find 341 Malicious ClawHub Skills, Feb 2 2026 ↩

- Semgrep, OpenClaw Security Engineer's Cheat Sheet, Feb 2026 ↩

- Kontan, Kerugian masyarakat akibat penipuan scam Rp 9,1 triliun hingga 14 Jan 2026 ↩

- OJK, Satgas PASTI imbau masyarakat waspadai penipuan menggunakan AI, 15 Nov 2025 ↩

- ArtificialIntelligenceAct.eu, Article 50 Transparency Obligations ↩

- European Commission, Guidelines and Code of Practice on transparent AI systems, Sept 26 2025 ↩

- Reuters, Spain to impose massive fines for not labelling AI-generated content, Mar 11 2025 ↩

- BPK RI, UU No. 27 Tahun 2022 tentang Pelindungan Data Pribadi ↩